Wielu specjalistów najchętniej schowałoby głowy w piasek, gdyby zapytać ich o ryzyko fraudów w marketingu, wynikających z internetowego non-human traffic – czyli ruchu generowanego przez boty, programy, skrypty i innych nie-ludzi. Jednak problem istnieje, co więcej, jest jedną z największych bolączek reklamodawców – zwłaszcza od momentu, kiedy ludzie stali się w internecie mniejszością.

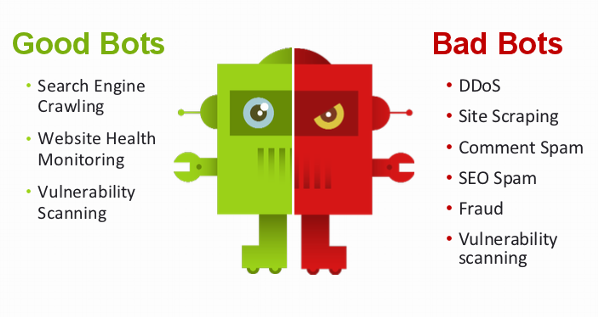

Na początku warto jednak zauważyć, że nie każdy ruch pochodzący od nie-ludzi jest dla nas niekorzystny. Boty dzielą się bowiem na dobre i złe. Jeśli ruch botów stanowił w ostatnich latach niemal 60% całego ruchu w internecie, to ponad połowę stanowiły właśnie działania „dobrych botów” – narzędzi pomagających wyszukiwarkom np. w indeksowaniu stron. Przykładami takich narzędzi są Google Crawler Bot, Facebook Externat Hit czy używany na aukcjach internetowych Trader Bot.

Jednak dla nas ważniejsze będą czarne owce wśród botów – te, które spędzają sen z powiek marketerom rozliczającym się w niemal każdym modelu rozliczeń reklamy internetowej. Jak pokazują tegoroczne raporty, tylko w 2016 roku ich ruch będzie kosztował branżę reklamy digitalowej ponad 7 miliardów dolarów. Reklamy video w prawie 25% wyświetlane są przez boty, podobnie jak 11% reklam typu display.

Pierwsze pytania, na które spróbujemy odpowiedzieć w tym tekście brzmią: czy możemy całkowicie unieszkodliwić ruch botów na stronie? Czy poradziły sobie z tym najlepsze strony na świecie?

Odpowiedź brzmi – nie. Boty coraz lepiej naśladują poruszanie się człowieka po systemie, po kliknięciu w reklamę przechodzą na stronę klienta, oglądając video, wypełniając leady i wchodząc na coraz wyższy poziom walki z marketerami szukającymi efektywnych rozwiązań dla ograniczenia ich roli – innymi słowy, selekcja mająca na celu oddzielenie ruchu człowieka od bota staje się coraz trudniejsza. I będzie coraz gorzej.

Rozwój fraudów

Straty wynikające z ruchu botów to część większego zjawiska, jakim jest click frauds. Były product manager w AdSense i specjalista w zakresie click frauds, Shuman Ghosemajumder, jeszcze w 2007 roku definiował 2 podstawowe typy fraudów. Pierwszy z nich to kliknięcia firm, które poprzez tego typu działania generują wyższe koszty reklamy dla konkurencji w ramach Google AdWords, drugi – to zwiększenie wiarygodności wydawcy w AdSense przez fałszywe kliki osób niezainteresowanych reklamą. W dużym uproszczeniu, non-human traffic rozszerzył celowość fraudu– boty przeszukują strony w poszukiwaniu luk, pobierają informacje ze strony, ułatwiają wysyłanie spamu i nie przynoszą stronom czy reklamom żadnych korzyści. Innymi źródłami fałszywego ruchu mogą być choćby farmy klików czy sieci typu botnet.

Najczęściej boty atakują w czterech obszarach, które można wyodrębnić na podstawie modelu rozliczenia:

CPM (lub CPV w przypadku video) – boty generują fałszywy ruch na reklamach, zawyżając liczbę odsłon i tym samym koszty dotarcia do 1000 odbiorców

CPC – w którym boty „wyklikują” reklamę, uniemożliwiając ocenę jej efektywności

CPL – boty symulują akcję, zapisując się np. do bazy mailingowej, co przynosi straty zwłaszcza przy modelu rozliczenia za pozyskanie leada (adresu e-mail i innych podstawowych danych)

CPA – złośliwe działanie botów jest możliwe również w przypadku, gdy reklamodawca ponosi koszt jedynie za reklamę przynoszącą konkretną akcję sprzedażową – żeby zminimalizować ryzyko należy przystosować formularz zakupowy.

Boty upodobały sobie pewne branże bardziej niż inne – z badań wynika, że branża finansowa oraz firmy gastronomiczne muszą mierzyć się z ruchem botów na poziomie między 16% a 22%. Technologie, sport i nauka mają mniejszy problem – w tych dziedzinach „zainteresowanie” botów ogranicza się do 3-4%. Co nie znaczy, że nie powinny one zawalczyć o dalsze ograniczanie fałszywego ruchu – jak to robić?

Podstawowe rozwiązania

Co oczywiste, Google walczy z non-human traffic już od wielu lat. Opracowane przez firmę algorytmy pozwalają na ograniczenie tego typu działań do mniej niż 10%. Dzięki danym z Google Analytics możemy przeanalizować ruch na stronie i ręcznie zablokować te adresy, które napędzają ruch z podejrzanych źródeł. Przydadzą się choćby dane geotargetingowe – wzmożony ruch z Chin czy Niemiec może być wyraźnym sygnałem „zabotowania” strony. Przeanalizuj też dublujące się adresy IP, pamiętając jednocześnie, że nie każde wielokrotne kliknięcie z tego samego IP oznacza działanie bota. W ograniczaniu dostępu botów do twoich zasobów pomoże ci ręczna praca w pliku .htaccess. Dobrze dobrane słowa kluczowe, odpowiednio stargetowane reklamy, analiza bounce rate’u i regularny update czarnych list oraz zastosowanie filtrów z Analyticsa również pomogą ci w ograniczeniu ruchu botów.

Formularze na twoim landing page’u są wypełniane przez mało wiarygodne konta? Dobrym pomysłem pozostaje uzupełnienie ich o tzw. honepots (garnki miodu), czyli (między innymi) nisko interaktywne pułapki w postaci protokołów lub pól, które pozostają niedostrzegalne dla człowieka, a są wypełniane przez boty. To rozwiązanie, które cieszy się obecnie większym powodzeniem, niż utrudniające poruszanie się po stronie, nieco anachroniczne i zwyczajnie nieskuteczne zabezpieczenia typu captcha.